这里用卢松松博客与我自己的博客作为例子,给大家介绍使用Python写的文章采集工具。

一、卢松松博客文章的采集

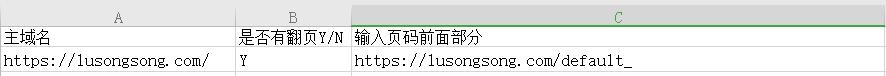

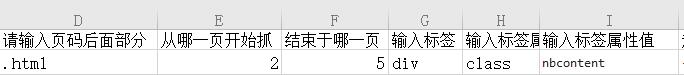

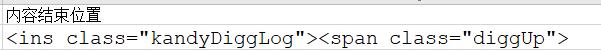

1、打开设置shezhi.xls,按照下面步骤设置

a、主域名下面填写https://lusongsong.com,记住域名后面的/不能要,否则会出错。

b、是否有翻页,但凡你要抓取的内容超过了一页,我们这里都选择Y,反之则选择N。

c、输入页码前面的部分

https://lusongsong.com/default_

d、输入页码后面的部分

.html

e、从哪一页开始抓

因为卢松松博客第一页是https://lusongsong.com/default,与后面的翻页页面规律不一样,所以这里我们从第二页开始抓,填写2就可以了

f、结束于哪一页

这里我们随便写,只要不是超过其原有的总页数就可以了,这里我就写抓取到第五页,填写5就可以了

g、输入标签

这里是需要找到文章列表在页面的什么地方,通常都会是一个div包含起来的,卢松松博客也确实是div包含起来的。所以这里填写div

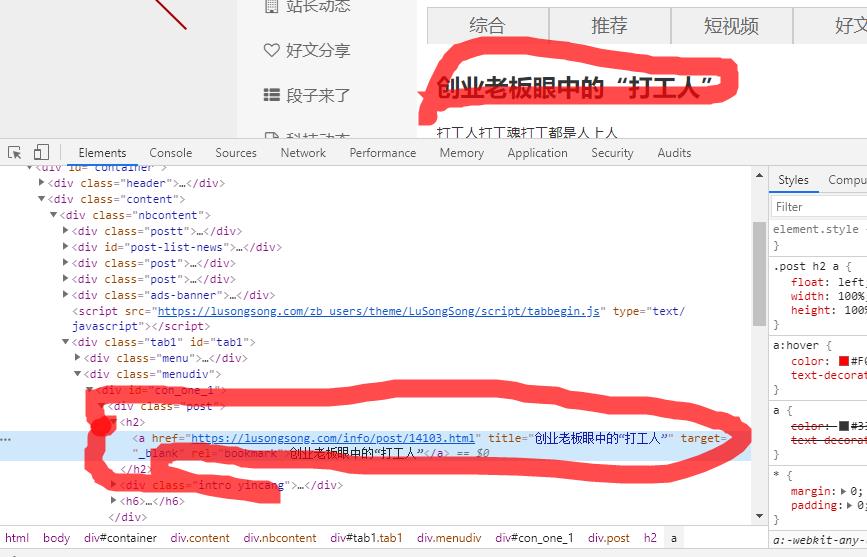

怎么找这个div

鼠标选中当前文章列表页中的某一篇文章,右键网页,点击审查元素,就会出现对应的文章被包含在什么html元素下,我们沿着这个往上找,一层一层的点,就能找到,整个文章列表页的位置。

h、标签属性有ID与class两种,卢松松博客里是class,所以这里我们填写class

i、属性值也就是id或者class后面的值,这里是nbcontent,所以填写nbcontent

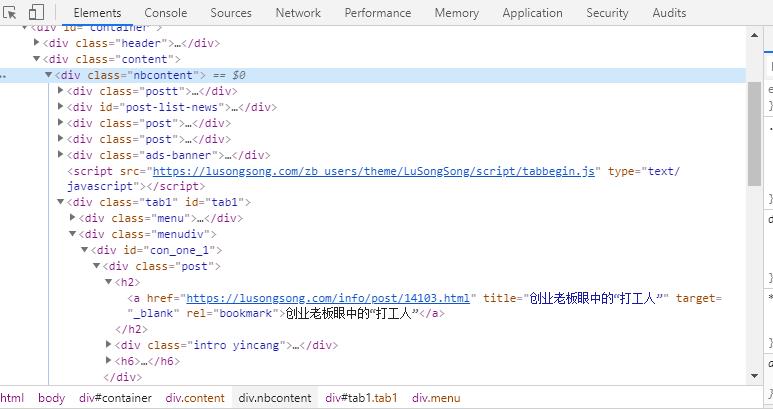

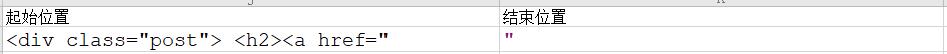

j、起始位置与结束位置,这里是要找到每一篇文章的URL

这里沿用g步骤,找到某一篇文章,右键点击审查元素,就可以找到,这里是<div class="post"> <h2><a href=",结束位置就很简单了没什么规律,我们只要看URL在哪里结束就可以了。这里这里就写"就可以了。

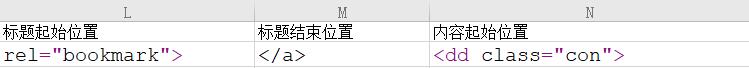

k、标题的起始位置与结束位置

打开某一篇文章的链接,进入文章页,同样鼠标选中标题,右键网页,审查元素

这里看到最靠近标题位置的是这一块代码rel="bookmark">,结束位置这里是一个a标签的结束标志</a>,为了正确,我们要看看是不是唯一的,右键网页,查看源代码,查找rel="bookmark">,这里只有一个,所以这样写没问题,如果有好几个,我们后面结束位置就要从新选择,要保证唯一性,这样才能准确找到标题。

l、内容起始位置设置

打开文章页的网页源代码,看文章第一句话前面的标志与文章最后一句话的标志。由于每篇文章有所不同,我们要多打开几篇文章看看,以保证,起始位置的包含所有页面的文章内容,防止有些网页文章内容抓不全。

m、缓冲时间,卢松松博客貌似有简单的反爬虫设置,这里我们需要设置下缓冲时间,这里我设置的是3,能够全部爬完,你可以设置小一点,如果不能爬完,再往大的设置。

全部设置完成后,如下图

接下来就是启动程序了,点击ads.exe,执行哪一行数据,这里因为我们写1,记住你在2下面设置的,就写1,在3下面设置的就写2,以此类推。

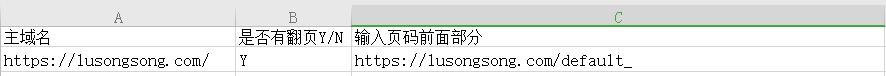

二、我自己的博客

爬取SEO基础的文章,由于第一URL是https://liaojinhua.com/seojichu/,第二页是https://liaojinhua.com/seojichu/2/,所以第一页数据暂时不爬。

重复以上步骤,设置完成后如下图;

关注下面公众号,回复采集工具,获取下载链接

评论