robot.txt是干嘛的,robot.txt的规范写法是怎样?

大家好,今天小编要给大家分享的是robot.txt是干嘛的,robot.txt的规范写法是怎样?,对于这个,启明seo非常认可,所以做个分享,希望能够对大家有所帮助。

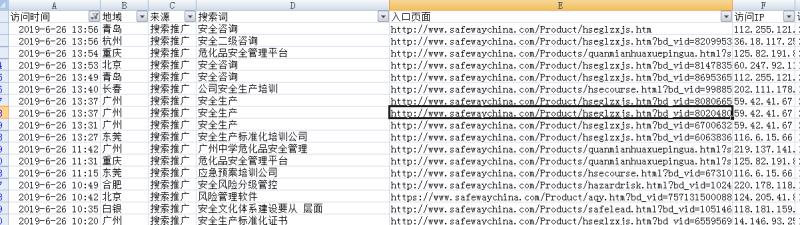

作为一名站长,检查网站日志是非常有必要的工作,通过日志我们可以知道蜘蛛抓取了哪些页面,通常我们会发现搜索引擎喜欢抓取动态的链接,那么我们可以通过robot.txt去屏蔽掉,不让它抓取,从而提升蜘蛛抓取效率,那么robot.txt是干嘛的,robot.txt的规范写法又是怎样呢?

robot.txt是干嘛的?

robots协议也叫robots.txt(统一小写)是一种存放于网站根目录下的ASCII编码的文本文件,它通常告诉网络搜索引擎的漫游器(又称网络蜘蛛),此网站中的哪些内容是不应被搜索引擎的漫游器获取的,哪些是可以被漫游器获取的。因为一些系统中的URL是大小写敏感的,所以robots.txt的文件名应统一为小写。robots.txt应放置于网站的根目录下。如果想单独定义搜索引擎的漫游器访问子目录时的行为,那么可以将自定的设置合并到根目录下的robots.txt,或者使用robots元数据(Metadata,又称元数据)。

简单来说说,网站的根目录需要放置一个txt文件,这个文件以robots命名,它是告诉搜索引擎我们网站上哪些页面可以抓取,哪些页面禁止抓取,从而提高搜索引擎的判断能力,同时搜索引擎也会遵循这一协议,双方各取所需。

robot.txt原则:

Robots协议是国际互联网界通行的道德规范,基于以下原则建立:

1、搜索技术应服务于人类,同时尊重信息提供者的意愿,并维护其隐私权;

2、网站有义务保护其使用者的个人信息和隐私不被侵犯。

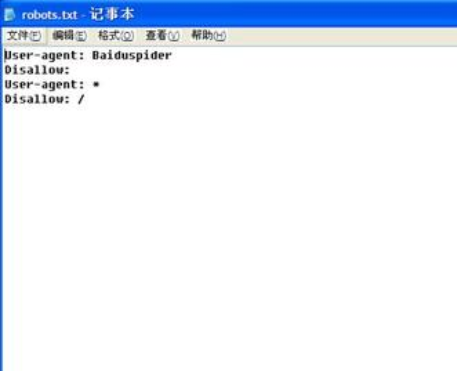

robot.txt的规范写法:

例1. 禁止所有搜索引擎访问网站的任何部分

User-agent: *

Disallow: /

禁止所有搜索引擎显然不符合我们的目的,一般在网站上线前可以禁止抓取,这样做是不让搜索引擎蜘蛛来抓取的时候网站是空的,而正常情况下我们只需要屏蔽掉一些不好的链接,比如动态链接,图片目录等就好。

例如:

User-agent: *

Disallow: /plus/ad_js.php

Disallow: /plus/advancedsearch.php

Disallow: /plus/car.php

Disallow: /skin

如果你觉得很复杂可以在站长工具平台在线生成robots.txt,只需要将不需要抓取的目录形式填写进去就可以一键生成。

robots文件重要性:

因此我们作为SEO人员建立robots.txt文件是很有必要的,网站中重复页面、重复的内容或者404错误页面都可以通过robots文件来屏蔽或阻止访问,否则搜索引擎蜘蛛就会认为该网站价值较低,从而导致搜索引擎给网站的评价降低。

实际上每一个网站都需要robot.txt文件,而很多站长朋友都忽略甚至压根不知道,看了此文后希望你给自己网站添加一个robot.txt,来帮助搜索引擎抓取更有效的信息,同时也可以将sitemap文件放入,增强蜘蛛抓取效率,提升网站收录很有效。如果你还有其他方面的问题欢迎和龙斗SEO博主交流互动。

推荐阅读:

robots文件怎么写,robots文件的作用是什么

这就启明seo就robot.txt是干嘛的,robot.txt的规范写法是怎样?做的所有分享,如果对您有所帮助,那将是我最大的动力,如果您有更好的看法,可以留言相互讨论。

评论