robots文件怎么写,robots文件的作用是什么?

启明seo今天要给大家分享的是robots文件怎么写,robots文件的作用是什么?,对于这个知识,小编也是研究了好久,觉得不错,才会给大家分享的,希望大家看了之后会对你们有所帮助。好了,现在开始正式分享。

在网站SEO优化的方法中,有一个内容是对robots文件的讲述,robots文件可以告诉搜索引擎我们的网站上哪些内容可以抓取,哪些内容不能抓取,这样搜索引擎就会知道自己该做些什么,下面就为大家分享robots文件怎么写,robots文件的作用是什么?

什么是robots文件?

robots文件是网站跟搜索引擎蜘蛛之间的一个协议,用来告诉蜘蛛,哪些文件是可以抓取的,哪些是不可以抓取的,搜索引擎蜘蛛只能按照robots文件里的约定进行抓取,如果我们有想要不被抓取的目录或是文件,我们可以写进robots文件中,robots文件通常只有放在根目录(www)才有效。切记!

robots文件的作用是什么?

1、可以屏蔽网站内一些打不开的链接,也就是死链接

2、可以屏蔽搜索引擎蜘蛛访问网站内重复的内容和重复的页面

3、阻止搜索引擎访问网站的隐私性的内容。

4、阻止搜索引擎访问网站的后台内容

5、告诉搜索引擎那些内容是需要被访问的

robots文件就像是一个网站看门管家,每个搜索引擎的蜘蛛来到网站后,先去询问robots文件看看哪些是可以访问的,就去抓取,哪些不能访问的就不抓取。如果网站没有robots文件,那搜索引擎就会访问服务器上的所有文件,哪些你不想展示的都会被抓取收录。

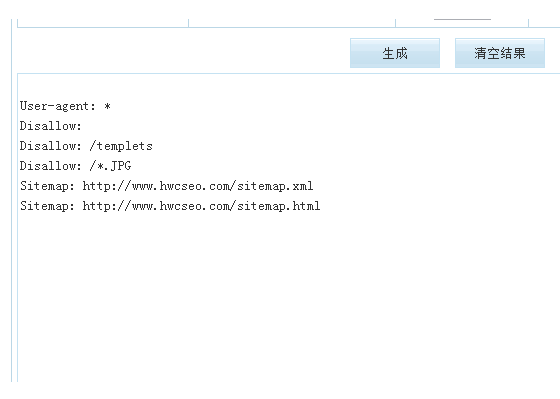

robots文件怎么写?

robots文件通用写法,有不会写robots文件的同学可以直接摘抄下面这一段:

User-agent: *

Disallow: /plus/ad_js.php

Disallow: /plus/car.php

Disallow: /plus/posttocar.php

Disallow: /plus/disdls.php

Disallow: /plus/feedback_js.php

Disallow: /plus/mytag_js.php

Disallow: /plus/rss.php

Disallow: /plus/search.php

Disallow: /plus/recommend.php

Disallow: /plus/stow.php

Disallow: /plus/count.php

Disallow: /include

Disallow: /templets

同时如果你有不想抓取的栏目或者链接可以用Disallow进行屏蔽,这里要提到一点,网站sitemap也是有必要写进robots文件中的。

robots文件使用技巧:

1. 每当用户试图访问某个不存在的URL时,服务器都会在日志中记录404错误(无法找到文件)。每当搜索蜘蛛来寻找并不存在的robots.txt文件时,服务器也将在日志中记录一条404错误,所以你应该在网站中添加一个robots.txt。

2. 网站管理员必须使蜘蛛程序远离某些服务器上的目录——保证服务器性能。比如:大多数网站服务器都有程序储存在“cgi-bin”目录下,因此在robots.txt文件中加入“Disallow: /cgi-bin”是个好主意,这样能够避免将所有程序文件被蜘蛛索引,可以节省服务器资源。一般网站中不需要蜘蛛抓取的文件有:后台管理文件、程序脚本、附件、数据库文件、编码文件、样式表文件、模板文件、导航图片和背景图片等等。

以上内容是关于“robots文件怎么写,robots文件的作用是什么”详细解答,相信看完文章的你一定了解了robots文件的使用方法,再次特别说明一下,如果你的网站有动态了解,那么一定将其屏蔽掉,否则搜索引擎就会抓取收录,对SEO优化有很大的影响。

这就启明seo就robots文件怎么写,robots文件的作用是什么?做的所有分享,如果对您有所帮助,那将是我最大的动力,如果您有更好的看法,可以留言相互讨论。

评论